下载

配置

sqoop-env.sh

1 | #Set path to where bin/hadoop is available 配置Hadoop |

添加MySQL连接jar包到$SQOOP_HOME/lib目录中

mysql-connector-java-5.1.31-bin.jar

验证

1 | [root@node1 sqoop]# bin/sqoop-version |

当才华撑不起野心时,应该静下心来学习;当能力驾驭不了目标时,应该沉下心来历练。

sqoop-env.sh

1 | #Set path to where bin/hadoop is available 配置Hadoop |

mysql-connector-java-5.1.31-bin.jar

1 | [root@node1 sqoop]# bin/sqoop-version |

导入数据

1 | create database test; |

导出数据

1 | bin/mysqldump -u username -p [-d] database_name > xxx.sql |

如果没有-d, 则导出表结构和数据;如果有-d,则只导出表结构

例如:1

bin/mysqldump -u root -p test > test.sql

1.下载解压安装包

下载链接:apache-hive-1.2.1-bin.tar.gz

1 | tar -xvf apache-hive-1.2.1-bin.tar.gz |

2.启动Hadoop

可以参考:Hadoop2.x配置HA

4.在$HIVE_HOME/bin目录下执行

1 | ./hive |

5.创建表test

1 | [root@node1 bin]# ./hive |

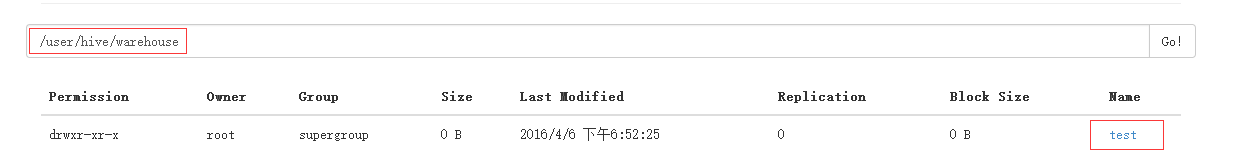

6.访问HDFS文件系统可以查看到test文件夹【创建一个表,就会在/user/hive/warehouse文件下创建对应的文件夹】

| Node Name | Master | ZooKeeper | RegionServer |

|---|---|---|---|

| node1 | yes | yes | no |

| node2 | backup | yes | yes |

| node3 | no | yes | yes |

1.配置conf/regionservers

1 | node2 |

2.创建conf/backup-masters

1 | node2 |

3.配置 hbase-site.xml

1 | <property> |

4.将配置文件拷贝到node2、node3中

1 | scp /csh/software/hbase-1.1.4/conf/* root@node2:/csh/software/hbase-1.1.4/conf/ |

5.启动HBase(在node1启动)

1 | ./start-hbase.sh |

6.jps查看结果

1 | //node1 |